Einige Wochen ist Linux Mint inzwischen bei mir im Betrieb, und ich muss zugeben, die erste Euphorie hat sich schnell gelegt, und auch von meinem Optimismus ist heute nicht mehr allzu viel übrig. Die ersten Erfahrungen mit dem neuen Betriebssystem sind auch begleitet von erster Ernüchterung über die vielen kleinen und mittelgroßen Steinchen, die es mir in den Weg legt. Im großen und ganzen läuft Linux Mint stabil und arbeitet ordentlich, aber ich bin dennoch nicht der Meinung, dass alles Sonnenschein ist. Ich wollte ursprünglich einen Artikel schreiben über positive und auch negative Aspekte des Betriebssystems, die mir bislang aufgefallen sind, aber die negativen Punkte liegen in einer solchen Vielzahl vor, dass ich alleine daraus einen Artikel schreiben kann. Im Folgenden also eine Liste der Störungen, die mir begegnet sind, geordnet von den schwerwiegendsten, über solche mit dem größten Nerv-Faktor, bis hin zu den unbedeutendsten.

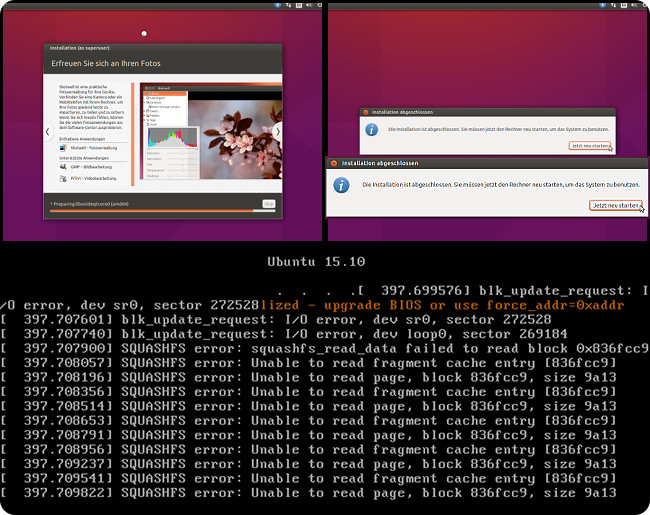

Der Knaller zuerst: Die Linux-Updates funktionieren bei mir schon nicht mehr. Nach einem der letzten Updates zeigte mir Mint plötzlich an, dass die Boot-Partition voll ist, und seitdem scheitern sämtliche Updates. Bei genauerer Betrachtung fällt auf, dass die Boot-Partition wohl nur 500 MB groß ist (hat Mint genau so angelegt, ich habe nichts dergleichen konfiguriert!), und Linux hat das Ding jetzt vollgemüllt und gibt den Platz nicht mehr frei. Super! Es ist erbärmlich für ein Consumer-Betriebssystem, dass es nicht „einfach funktioniert“, sondern im Gegenteil durch falsche Standardkonfiguration garantiert schon nach wenigen Updates die Updatefunktion komplett lahmlegt. Das ist dilettantisch. Dann muss ganz offensichtlich jemand dafür sorgen, dass die Standardkonfiguration eine andere ist. Inzwischen habe ich nachgelesen, dass ich Terminal-Befehle eingeben muss, um das Problem zu beseitigen. Keine GUI-Systemtools oder dringend nötige Betriebssystemautomatismen, die mir diese Arbeit abnehmen. Immer nur Terminalbefehle, um doofe Linux-Probleme zu beheben, die ich in anderen Betriebssystemen erst gar nicht hätte.

Einen Befehl zur Systemreinigung habe ich wieder einmal entgegen meiner Intention aus dem Internet ins Terminal kopiert (irgendwas mit „autoremove“ und „purge“), und sogar DER wirft Fehler („No space left on device“) und die Boot-Partition ist davon auch nicht freigeworden. Die üblichen Zeilen aus den Linux-Foren möge man sich hier als Echo in meinem Kopf vorstellen („Das ist so einfach!“, „Das kann wirklich jeder!“, „Einfach nur diesen Befehl hier eingeben und schon…“). Ich muss jetzt also eine Problemlösung im Internet suchen, um die defekte manuelle Systemreinigung zu reparieren, die nur nötig ist, weil es Mint nicht selbst gebacken bekommt seine Daten richtig zu ordnen? Liebe Ubuntu- und Mint-Entwickler, müssen die Nutzer eures Betriebssystems wirklich ein Informatikstudium absolvieren, damit sie es richtig bedienen können? Das kann doch nicht euer Ernst sein. Das sind Dinge, die das OS selbst verwalten können MUSS! Windows KANN das! Ich kann gar nicht soviel kotzen wie mich das jetzt schon nervt.

Beim Starten des Rechners, wenn ich das Kennwort für die Festplattenentschlüsselung eingeben soll, sind die USB-Geräte dummerweise noch gar nicht aktiv, so dass ich die Tastatur nicht verwenden kann. Ich muss dann den Resetknopf betätigen, damit Linux mir das Bootmenü anzeigt. Anschließend erscheint ein alternativer Bildschirmdialog, der ebenfalls das Kennwort für die Entschlüsselung erfragt – und hier ist die Tastatur zum Glück eingeschaltet und erlaubt die Eingabe. Aber jedes Mal bei einem erneuten Start des Systems muss ich wieder den Resetknopf drücken. Offenbar ist das ein altbekanntes Ubuntu-Problem, das in mehreren Jahren nie behoben wurde, obwohl es als kritisch eingestuft ist: https://bugs.launchpad.net/ubuntu/+source/plymouth/+bug/1386005

Der Filemanager meldet mir in schöner Regelmäßigkeit, dass es ein Problem mit meinem Thumbnail-Cache (Vorschaubildpuffer) gibt, das angeblich nur mit Root-Rechten beseitigt werden kann. Wieso muss der Nutzer mit solchem Kleinkram belästigt werden, und wieso kann das Betriebssystem den Fehler wieder nicht selbst beheben? Windows hat sich noch nie darüber beklagt, aber Linux muss da natürlich so wehleidig sein. Den Nutzer interessiert der Thumbnail-Cache überhaupt nicht, und er will nicht jedes Mal sein Passwort eingeben müssen, wenn – warum auch immer – mal wieder ein Vorschaubildchen kaputt gegangen ist.

Die Thumbnail-Generierung ist ohnehin der allergrößte Schwachsinn, das hätte man sich doch bitte bei Windows abgucken können. Wenn ich unter Linux ein sehr großes Verzeichnis mit tausenden Bildern öffne und irgendwo in die Mitte scrolle, dann berechnet der Dateimanager die Thumbnails. Alle Thumbnails. Von A bis Z berechnet er Thumbnails – minutenlang – und hört auch nicht mehr damit auf, erst wenn er irgendwann fertig ist. Die Festplatte rödelt sich tot, die CPU dreht hoch, es werden unnötig Ressourcen verschwendet. Und das geilste: Das macht er jedes Mal von vorne, wenn ich das Verzeichnis erneut öffne. Nemo berechnet die ganze Zeit Thumbnails für das ganze Verzeichnis und zeigt diese nach und nach an, während die Ansicht dabei permanent nach unten rutscht. Es ist kaum möglich in dieser Bewegung irgendwelche Dateien anzuklicken, weil alles an dir vorbeiscrollt. Wieso reicht es nicht, einfach nur die Thumbnails zu berechnen, die man aktuell im Fenster sehen kann? Große Verzeichnisse werden so automatisch zur Qual. Ich kann auch nicht so einfach zwischen Symbol-, Listen- oder Kompaktansicht hin- und herschalten, denn das dauert jedes Mal 1-2 Minuten, je nach Ordnergröße.

Meine externen Festplatten wurden beim ersten und zweiten Mal nach der Installation automatisch mit eingehängt, danach plötzlich nicht mehr. Scheint doch sehr willkürlich zu sein. Offenbar hängt Linux Festplatten beim Systemstart nicht immer automatisch ein. Ich musste erst einmal recherchieren, wie man Festplatten „manuell automatisch“ einhängen kann. Wieso muss ich Festplatten überhaupt manuell automatisch einhängen, wenn ich sie doch immer angeschlossen habe? Ach Mensch…

Das Tool zur Analyse der Festplattenbelegung funktioniert bei mir nicht richtig: Ich bekomme angezeigt, dass der größte Teil der Festplatte durch ein Verzeichnis „ecryptfs“ verbraucht wird, und darin sind nur …nunja … kryptische Dateien, die viel Platz brauchen. Wieso bekommt das Analysetool die Dateien nur in verschlüsselter Form zu sehen, wo ich im Dateimanager entschlüsselte Daten sehe?

Ich bin absolut kein Fan dieser unsichtbaren Mouseover-Scrollbalken, die Linux Mint überall forciert, also Scrollbalken die nicht sichtbar sind, erst wenn man den Fensterrand erreicht, werden sie eingeblendet. Das große Problem hierbei ist, dass mehrere Programme (wie z.B. Eclipse) den Bereich für die Scrollbalken dadurch nicht mehr RESERVIEREN, sondern als nutzbare Fensterfläche verwenden. Möchte ich also mit der Maus dort den Cursor hinter das letzte Zeichen einer langen Textzeile setzen, klicke ich unabsichtlich auf den vertikalen Scrollbalken, der dort sofort erscheint, weil der Scrollbalken ÜBER DEN TEXT gelegt wird. Es ist also mit der Maus überhaupt nicht mehr möglich, den Cursor an die richtige Stelle zu setzen, weil der Scrollbalken immer im Weg ist. Wer entwickelt so eine dämliche Scheiße?

Ganz zu schweigen von diesen extraschmalen Fenster-Titelleisten, die sich farblich nicht einmal von der Menüleiste unterscheiden und dadurch größer aussehen als sie sind. Möchte ich das Fenster also kurz an der Titelleiste anklicken um es irgendwohin zu ziehen, klicke ich fast immer erst daneben, nämlich in den Bereich der Menüleiste, weil da viel mehr Fläche zum Anklicken ist. Könnte man die Fenster nicht einfach auch im leeren Bereich der Menüleiste verschiebbar machen?

Gelegentlich, mehrmals täglich, flackern alle möglichen Fenster schwarz, manchmal der Desktophintergrund, manchmal der halbe Bildschirm, manchmal nur kleinste Teilbereiche von geöffneten Fenstern. Alle paar Stunden flackert irgendwas für ein paar Sekunden, und hört dann plötzlich wieder auf. Ich müsste Linux dafür nicht unbedingt die Schuld geben, da es vermutlich ein Treiberproblem ist, aber da ich nunmal eine Nvidia-Grafikkarte von der Stange verwende, und den offiziellen Treiber, und da Windows keine solchen Probleme hat, stört es mich doch sehr. Auch ein neuer Nvidia-Treiber hat nichts geändert. Offenbar ein steinaltes Ubuntu-Problem, und offenbar auch nach Jahren noch nicht behoben: http://askubuntu.com/questions/263996/fixing-the-nvidia-graphics-screen-flicker-issue

Manchmal, wenn ich via DRUCK-Taste bzw. mit ALT-DRUCK einen Screenshot anfertigen will, erkenne ich auf dem Bild mehrere merkwürdige schwarze Streifen, bzw. schwarze schmale Blöcke, mittig und rechts, die (offenbar immer an denselben Stellen) Bereiche des Bildes verdecken. Nicht immer, aber immer öfter.

Bei großen Dateitransfers von bzw. auf USB-Platten, bewegt sich der Mauszeiger plötzlich nur noch ruckartig durchs Bild, scheint immer wieder kurz hängenzubleiben, trotz gleichmäßiger Bewegung der Maus. Auch Tastatureingaben scheinen immer wieder für Bruchteile von Sekunden zu hängen, und auch Fenster bauen sich oft erst mit Verzögerung und erkennbar schrittweise auf. Es scheint mir so, dass Linux Probleme mit der Höherpriorisierung von USB-Eingabegeräten bzw. der CPU-Priorisierung hat, und dem Kopiervorgang alles andere unterordnet. Kein großes Problem, aber ein ziemlich dämliches, unnötiges.

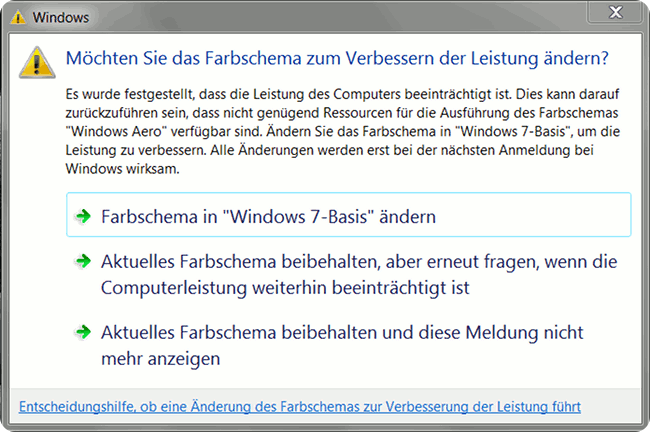

Ich bin nicht besonders begeistert davon, wie unrund und ungeschliffen das Betriebssystem in vielen Kleinigkeiten ist. Vieles wirkt irgendwie ambitioniert, aber dann leider nicht ausreichend gut durchdacht. Im Endeffekt kommt alle paar Tage etwas dazu, was mir die ganze Sache noch ungenießbarer macht, mich noch mehr ärgert. Einiges davon mag daher rühren, dass es „nicht wie Windows ist“, und ich mich eigentlich nur richtig daran gewöhnen müsste, andere Probleme, wie die defekte Updatefunktion, die flackernden Fenster, dass die USB-Geräte beim Hochfahren nicht rechtzeitig eingeschaltet werden, und dass das Betriebssystem bei Kopiervorgängen manchmal grundlos herumruckelt, haben definitiv nichts mit meiner Windows-Sichtweise zu tun.

Ich fürchte an dieser Stelle muss ich meine vorschnelle Empfehlung von Linux als Betriebssystem für Windows-Umsteiger zurückziehen. Linux ist tatsächlich NUR Leuten zu empfehlen, die wirklich großen Spaß daran haben, kryptische Befehle aus Foren in das Terminal zu kopieren und Konfigurationsdateien von Hand anzupassen. Für alle anderen, die nicht basteln wollen, für die das Betriebssystem „einfach nur funktionieren“ soll, sind Windows und macOS die WEITAUS bessere Wahl, auch im Jahr 2017, so schwer es mir fällt, das zu bestätigen. Die Linuxer sind stolz darauf, wenn sie ihre geliebten Befehle ins Terminal tippen dürfen, und darum wird sich an der Usability des Betriebssystems vermutlich auch nie etwas ändern.