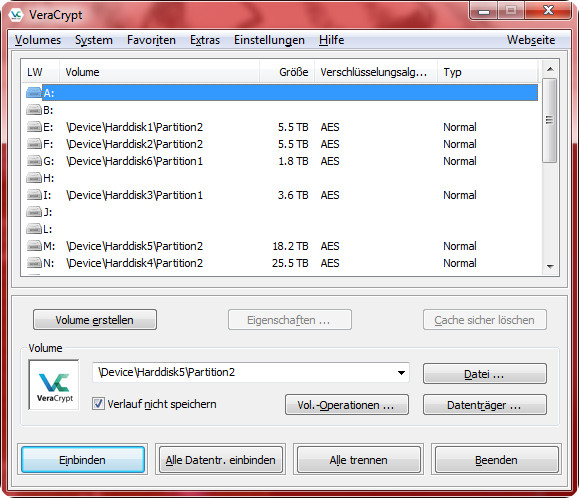

Ein kleiner Schritt für einen Nerd, ein weiterer Meilenstein auf meinem Pfad in die eigene Datensouveränität: Alle meine Festplatten sind heute vollständig verschlüsselt. Ja, irgendwann habe ich es einfach gewagt, Veracrypt installiert und damit begonnen, einen Datenträger nach dem anderen zu verschlüsseln. Zunächst vorsichtshalber nur bei Festplatten, die komplett redundant gesichert sind, um es anzutesten. Nach den ersten Monaten ohne Schwierigkeiten dann schließlich durchgängig bei allen anderen Festplatten. Ich habe bei dem Thema zuvor lange mit mir gerungen, und den Grund dafür werde ich in den folgenden Absätzen gerne kurz anreißen, denn es sind Dinge, die man hierzu unbedingt wissen sollte.

Schon damals im Studium im Jahr 2007 habe ich mit dem Veracrypt-„Vorgänger“ Truecrypt ein wenig experimentiert. So erstellte ich mehrere verschlüsselte Datencontainer auf meiner Festplatte, mit einem sicheren Passwort versehen, und kopierte einige Dateien hinein. Die Container konnten schon damals relativ einfach immer bei Bedarf wie ein eigenes Laufwerk unter Windows gemountet werden, was mir grundsätzlich sehr gefiel. Erstellt habe ich sie in Größen von 1 bis 2 GB und mit allerlei Dateien gefüttert, hauptsächlich Spiele und anderen Kram, den ich ohnehin auslagern wollte. Nichts Wichtiges zum Glück. Das hat eine Weile nämlich ganz gut funktioniert. Bis der größte der Container ganz plötzlich von heute auf morgen das Passwort nicht mehr akzeptiert hat. Eine Internetsuche zu dem Problem brachte mich auf die Idee, das Headerbackup, das man zuvor angelegt hatte, wieder auf den Container einzuspielen. Das Einspielen gelang, aber das Passwort nahm Truecrypt im Anschluss trotzdem nicht an. Eine längere Internetsuche brachte keine weitere rettende Idee. Die Dateien waren natürlich alle noch da, aber ich kam nicht mehr dran, und so verabschiedete ich mich bald davon. Das Experiment war gescheitert. Heute, 12 lange Jahre später, kann ich auch nicht mehr mit hundertprozentiger Gewissheit sagen, ob ich mich vielleicht mit dem Passwort vertan hatte, oder ob der Container doch irgendwie beschädigt wurde. Aus Erfahrung weiß ich beispielsweise, dass Scandisk/Checkdisk von Windows bei mir auch gerne mal große Dateien kaputtrepariert hat. Wäre also nicht so abwegig gewesen.

Ich lernte damals, von Truecrypt doch besser Abstand zu nehmen, denn man kann sich leicht daran die Finger verbrennen. Auch heute, wenn man in Internetforen nach Problemen mit Truecrypt/Veracrypt sucht, wird man überhäuft von Meldungen über plötzlichen Datenverlust durch Fehlfunktionen und verschlüsselte Container, die sich nicht mehr öffnen lassen bzw. das Passwort einfach nicht mehr akzeptieren. Viele verzweifelte oder verärgerte Hilferufe von Nutzern, die kein Backup haben und jemanden suchen, der ihre Daten retten kann – zur Not sogar gegen viel Geld. Offenbar ist dieses Thema selbst heute noch mit großer Vorsicht zu genießen, denn wird der Container durch einen Schreibfehler beschädigt, kann es im ungünstigsten Fall passieren, dass die Gesamtheit der Dateien sich in Sekundenschnelle in unlesbaren Datenmüll verwandelt. Bei einer unverschlüsselten Festplatte hätte man hier zumindest noch die Chance, alle unbeschädigten Daten zu extrahieren. Eine Festplattenverschlüsselung bietet ein ausgezeichnetes Maß an Schutz der Daten vor fremdem Zugriff, aber macht die Datenrettung bei einem Festplattendefekt leider gleichzeitig extrem schwer, wenn nicht sogar unmöglich. Ein großer Vorteil also, der im Katastrophenfall zu einem großen Nachteil werden kann.

Festplattenverschlüsselung taugt also gar nicht für den Alltag? Viel zu unsicher? Ganz im Gegenteil! Jeder, der mit dem Gedanken spielt, seine Dateien zu verschlüsseln, sollte sich natürlich darüber im Klaren sein, dass es unverzichtbare und verzichtbare Daten gibt. Unverzichtbares wird bei mir redundant an zwei Orten gleichzeitig gelagert und verschlüsselt. Fällt ein Datenmedium aus, habe ich immer ein Backup. Wer es sich leisten kann, setzt sogar auf mehrfache Redundanz, im Idealfall räumlich getrennt. Verzichtbares kann ich logischerweise auch ohne Backup verschlüsseln. Fällt dieses Datenmedium aus, ist der Tag womöglich ruiniert, aber ich breche nicht gleich in Tränen aus. Pech gehabt, das Leben geht weiter. So handhabe ich das im Moment. Alles wird verschlüsselt, aber nur das Wichtigste wird als Backup vorgehalten. Ein bisschen Risiko ist immer im Spiel.

Wie sieht meine bisherige Erfahrung nach mehreren Monaten mit Festplattenverschlüsselung aus? Derzeit habe ich 16 vollständig verschlüsselte Festplatten im Einsatz. Davon 5 im NAS, 2 intern, und 9 extern. Das entspricht insgesamt 105 Brutto-Terabyte (rein nach Herstellerangaben). Bislang sind keine Ausfälle oder Fehler zu beklagen. Selbst das mehrfache harte „Ausstöpseln“ von USB-Datenträgern durch ein Versagen der Stromversorgung hat Veracrypt gut überstanden, obwohl es jedes Mal eine Warnmeldung ausgegeben hat. Eine Schrecksekunde gab es, als die größte Festplatte sich irgendwann nicht mehr mounten ließ. Traumatisierende Flashbacks an den großen Datenverlust von 2007 geisterten mir sofort im Kopf herum. Nach einem Neustart und einem doch noch erfolgreichen Einhängen der Platte dämmerte es mir, dass ich wohl versehentlich unter Veracrypt die falsche Partition auf dem richtigen Laufwerk mounten wollte. Es handelte sich offenbar um diese komische unzugängliche Recovery-Partition auf WD-Festplatten, die mir zur Auswahl angezeigt wurde.

Keine Probleme also bei mehr als einem Dutzend verschlüsselter Festplatten. Keine schlechte Leistung. Also alles gut? Nunja, ich rechne noch mit dem ersten Ausfall im Lauf der Zeit. Vermutlich früher als mir lieb ist. Und dann hoffe ich, dass es eine der Festplatten trifft, die von mir regelmäßig gespiegelt werden. Eine gute Datenpflege und -strategie ist dabei natürlich unerlässlich, wenn man mit sovielen Datenträgern hantiert. Veracrypt macht es mir leicht, indem es beim Anschließen einer Festplatte sofort ein Password-Prompt einblendet und unaufgefordert das Einhängen übernimmt. Bis jetzt bin ich wirklich beeindruckt wie gut es funktioniert, und es beruhigt mich sehr. Wenn ich bisher alte Festplatten entsorgen wollte, musste ich zuvor daran denken, alles komplett zu formatieren, oder falls nicht mehr möglich, die Festplatte mechanisch zu zerstören. Der Inhalt einer verschlüsselten Festplatte ist dagegen völlig unbrauchbar für andere Personen, sie enthält quasi nur unverständliches Rauschen. Ich könnte also jede meiner Festplatten einer wildfremden Person in die Hand drücken, und meine Daten wären trotzdem sicher. Viel zu wenige Menschen machen sich Gedanken über den Inhalt ihrer weggeworfenen Festplatten, und was man davon noch problemlos rekonstruieren könnte.

Aus meiner Sicht war es mittlerweile wirklich an der Zeit, künftig ausschließlich mit verschlüsselten Daten zu arbeiten. Festplattenverschlüsselung ist heute absolut kein Hexenwerk mehr, die Möglichkeiten besser als je zuvor, der Aufwand hält sich stark in Grenzen. Ja, man muss beim Booten mehr Passwörter eingeben (oder Keyfiles angeben), aber die Vorteile überwiegen die Nachteile bei weitem. Es ist fahrlässig, seine Daten offen herumliegen zu lassen. Davon wird mindestens jeder ein Lied singen können, dessen Laptop einmal gestohlen wurde, oder der bereits Opfer einer Hausdurchsuchung geworden ist. Besser kein Risiko eingehen. Aber kostet das Lesen und Schreiben auf eine verschlüsselte Festplatte denn nicht viel mehr Performance? Nein, überhaupt nicht, denn AES-Verschlüsselung wird hardwareseitig in Echtzeit unterstützt. Es macht keinen Unterschied. Und mit Veracrypt bekommt man eine leistungsfähige, sichere und offene Softwarelösung, die zudem auch nichts kostet.

Ich kann also jetzt endlich guten Gewissens einen weiteren Punkt auf meiner Datenschutz-Checkliste streichen und werde mich hoffentlich im kommenden Jahr schon um den nächsten kümmern.